Современный мир невозможно представить без центров обработки данных, которые служат негласным «сердцем» всей цифровой экономики. Внутри этих высокотехнологичных комплексов, будь то коммерческий ЦОД или частная серверная, круглосуточно кипит напряженная работа: серверы, системы хранения данных и сетевое оборудование обрабатывают и передают колоссальные объемы информации, обеспечивая бесперебойную работу критически важных сервисов. Однако у этой непрерывной деятельности есть один серьезный побочный эффект — колоссальное выделение тепла.

Избыточная тепловая энергия, выделяемая тысячами процессоров, является главной угрозой для стабильной и надежной работы всей IT-инфраструктуры. Без эффективного охлаждения оборудование быстро перегревается, что приводит к снижению производительности, сбоям и даже полному выходу из строя. Управление температурным режимом становится одной из самых сложных и дорогостоящих задач при эксплуатации дата-центров.

В этой статье мы глубоко погрузимся в мир технологий охлаждения центров обработки данных. Мы подробно разберем, почему перегрев так опасен, что такое коэффициент энергоэффективности PUE, какие бывают системы охлаждения и как правильно рассчитать их мощность. Это руководство поможет вам понять, как обеспечить оптимальные условия для вашего оборудования, повысить его надежность и значительно сократить эксплуатационные расходы.

Содержание

- Зачем ЦОДам нужны системы охлаждения

- Что такое коэффициент PUE

- Основные технологии и решения для охлаждения дата-центров

- Как рассчитать мощность системы охлаждения ЦОД

- Заключение

- Ответы на частые вопросы

Зачем ЦОДам нужны системы охлаждения

Работа оборудования в центрах обработки данных невозможна без грамотно спроектированных и постоянно функционирующих систем охлаждения. Они выполняют несколько ключевых функций: отвод избыточного тепла, подача свежего охлажденного воздуха, поддержание оптимального уровня влажности и очистка воздуха от пыли. Несоблюдение этих условий создает серьезные риски для бизнеса и может привести к непредсказуемым последствиям.

Последствия перегрева: что происходит с оборудованием без охлаждения?

Критические температуры являются основной причиной сбоев и отказа серверного оборудования. Когда техника работает в условиях, выходящих за рамки рекомендованного производителем температурного диапазона, ее компоненты подвергаются ускоренному износу. Например, при температуре выше 30°C резко снижается срок службы жестких дисков. Работа оборудования при максимально допустимой температуре не гарантирует, что оно прослужит так же долго, как при более низких значениях.

Перегрев вызывает целый каскад проблем, ведущих к увеличению общей стоимости владения инфраструктурой. Сначала снижается производительность, затем возникают программные сбои и, в конечном счете, преждевременный выход из строя одного или нескольких серверов. Это приводит к простоям, потере критически важных данных и временной недоступности клиентских сервисов. Затраты на постоянный ремонт и замену вышедших из строя компонентов становятся значительным финансовым бременем. Таким образом, инвестиции в качественные и надежные системы охлаждения — это не просто расходы, а стратегическое вложение в долгосрочную экономию, стабильность и непрерывность бизнес-процессов.

Идеальный микроклимат для стабильной работы серверных

Для эффективной и надежной работы серверов и другого оборудования необходимо точное поддержание целого ряда климатических параметров. Рекомендуемая температура в машинном зале, согласно отраслевым стандартам, должна находиться в диапазоне от +18°С до +24°С, но не превышать +25°С. При этом оптимальный уровень влажности воздуха составляет 40-60%. Отклонение от этих показателей может привести к нежелательным последствиям: слишком высокая влажность может вызвать коррозию, а слишком низкая — накопление статического электричества.

Также критически важной является чистота воздуха. Содержание пыли в помещении не должно превышать 0,75 мг на кубический метр, а приточный воздух должен проходить многоступенчатую фильтрацию, соответствующую классу EU4. Частицы пыли могут оседать на микросхемах и радиаторах, ухудшая теплоотвод и вызывая локальный перегрев, который, в свою очередь, может привести к коротким замыканиям. Таким образом, успешное охлаждение ЦОД — это не только снижение температуры, но и комплексное управление всем микроклиматом помещения, что требует многофункциональных и интегрированных решений.

Что такое коэффициент PUE

Оценка эффективности дата-центра требует использования стандартизированных метрик. Одной из ключевых является коэффициент эффективности использования электроэнергии, известный как PUE (Power Usage Effectiveness). Эта метрика позволяет оценить, насколько эффективно ЦОД использует энергию, и является одним из самых важных показателей его инженерной зрелости.

Что такое PUE и почему он важен?

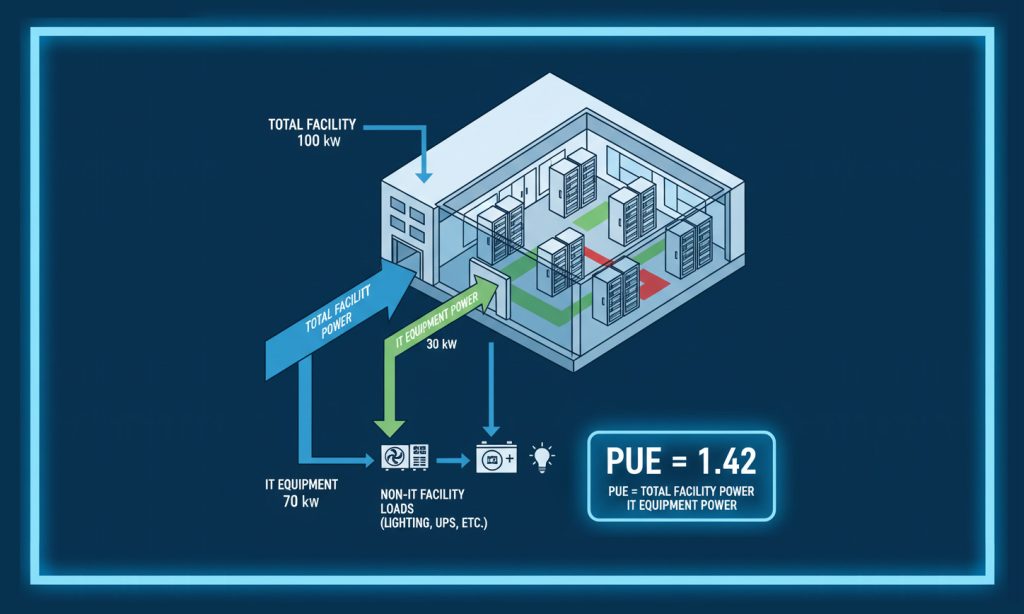

PUE — это соотношение общего количества электроэнергии, потребляемой всем центром обработки данных, к объему энергии, используемой непосредственно IT-оборудованием. Другими словами, этот показатель демонстрирует, какая доля энергии уходит на обеспечение вспомогательной инфраструктуры — системы охлаждения, освещение, ИБП и другие инженерные системы. Изначально метрика PUE была введена не столько из-за стремления к экологичности, сколько из-за финансовых соображений. В начале XXI века, когда стоимость электроэнергии начала стремительно расти, провайдеры столкнулись с огромными операционными расходами. Возникла острая необходимость найти способ оптимизировать энергопотребление, и PUE стал инструментом для оценки и сравнения эффективности различных решений.

Низкий показатель PUE указывает на то, что дата-центр более эффективно управляет своей инфраструктурой, что в конечном итоге приводит к значительной экономии на счетах за электричество. Более того, оптимизация PUE также позволяет повысить надежность ЦОД и улучшить его пропускную способность. Поиск и внедрение инновационных технологий охлаждения, направленных на снижение PUE, становится ключевым конкурентным преимуществом на рынке.

Как рассчитать PUE?

Формула для расчета PUE выглядит следующим образом:

PUE = Общее энергопотребление ЦОД / Энергопотребление IT−оборудования

Идеальное значение, при котором вся энергия тратится только на вычислительное оборудование, равно 1,0. На практике такой показатель недостижим, поскольку часть энергии всегда будет уходить на охлаждение, освещение и другие системы. Однако стремление к этой отметке является главной целью для операторов дата-центров. Превосходными показателями на сегодняшний день считаются значения PUE в диапазоне 1,10–1,15.

Достижение низкого PUE является показателем уровня развития инженерной инфраструктуры. Это требует внедрения сложных и высокотехнологичных решений, таких как фрикулинг и иммерсионное охлаждение. Использование таких технологий повышает не только энергоэффективность, но и общую надежность, а также пропускную способность центра данных, что делает его более привлекательным для клиентов.

Основные технологии и решения для охлаждения дата-центров

Выбор системы охлаждения — это фундаментальное решение, которое определяет не только первоначальные капитальные затраты, но и долгосрочные операционные расходы, а также потенциал для масштабирования инфраструктуры. Существует несколько основных подходов к охлаждению центров обработки данных, каждый из которых имеет свои особенности.

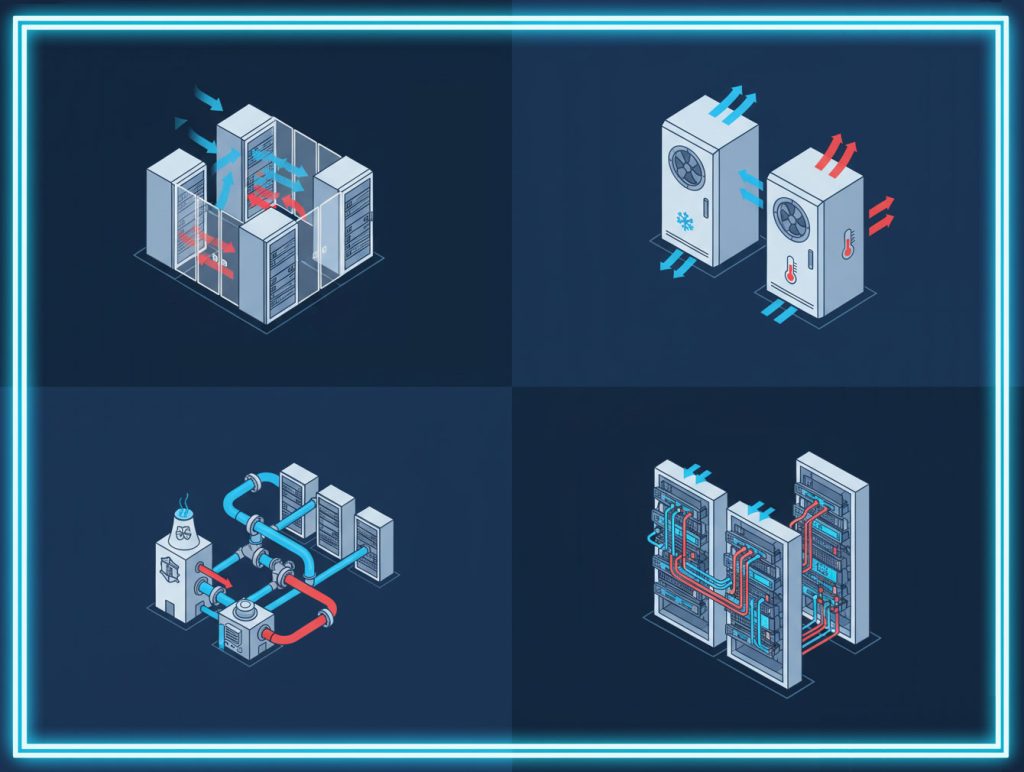

Воздушное охлаждение

Воздушное охлаждение является наиболее распространенной и традиционной технологией в индустрии. Она основана на циркуляции воздуха, который забирает тепло от оборудования и передает его кондиционерам или другим охлаждающим элементам. Обычно в таких системах используются прецизионные кондиционеры, которые могут быть потолочными, шкафными или межрядными. Ключевой принцип — разделение воздушных потоков на горячие и холодные коридоры. Межрядные кондиционеры, устанавливаемые между IT-стойками, забирают нагретый воздух из горячего коридора и подают охлажденный в холодный.

Преимущества воздушного охлаждения заключаются в его относительной простоте и более низкой начальной стоимости по сравнению с жидкостными решениями. Однако у этой технологии есть существенные недостатки. Она не отличается высокой энергоэффективностью и имеет ограничения по плотности размещения оборудования, поскольку высокая концентрация серверов в стойке приводит к локальному перегреву, с которым обычные кондиционеры справляются с трудом.

Жидкостное охлаждение

Развитие высокопроизводительных вычислений, искусственного интеллекта и машинного обучения привело к экспоненциальному росту тепловыделения от оборудования, особенно от мощных GPU. Воздушные системы больше не способны эффективно отводить такой объем тепла, что сделало жидкостное охлаждение не просто альтернативой, а необходимостью. Эта технология использует жидкие теплоносители — воду, минеральное масло, фторсодержащие жидкости — которые обладают гораздо большей теплоемкостью и плотностью, чем воздух.

Существует несколько подходов к жидкостному охлаждению:

- Охлаждение с помощью холодных пластин (Direct Liquid Cooling, DLC): жидкость циркулирует по специальным пластинам, закрепленным на горячих компонентах (CPU, GPU), отводя от них тепло.

- Иммерсионное (погружное) охлаждение: оборудование полностью погружается в специальную диэлектрическую жидкость. Эта технология позволяет отводить до 150-250 кВт чистой мощности на стойку, достигая феноменально низких значений PUE — до 1,05.

Жидкостное охлаждение обладает рядом неоспоримых преимуществ: высочайшая энергоэффективность, возможность значительно повысить плотность размещения оборудования, снижение занимаемой площади машинного зала до 5-10 раз и полное отсутствие шума от вентиляторов. Однако внедрение таких решений сопряжено с высокими капитальными затратами и требует радикальной перестройки инфраструктуры существующих дата-центров.

Фреоновое и гибридное охлаждение

Традиционные фреоновые системы охлаждения используют компрессоры, которые сжимают фреон для отвода тепла. Однако сегодня наиболее перспективным решением является фрикулинг (от англ. free cooling — «бесплатное охлаждение»). Эта инновационная технология использует холодный наружный воздух для отвода тепла, что позволяет отключать или значительно снижать нагрузку на энергоемкие компрессоры в холодное время года. Адиабатическое охлаждение, еще один интеллектуальный подход, основан на эффекте испарения воды: распыляемая в горячем воздухе вода испаряется, поглощая тепло и снижая температуру.

Будущее охлаждения центров данных, вероятнее всего, за гибридными системами. Такие решения сочетают в себе несколько технологий, используя преимущества каждой из них в зависимости от внешних условий и текущей нагрузки. Например, в холодное время года система может полностью переходить на фрикулинг, а при повышении температуры автоматически включать механическое охлаждение. Такой подход позволяет достичь максимальной энергоэффективности, снизить PUE и повысить общую надежность инфраструктуры, предлагая оптимальный баланс между производительностью и экономичностью.

Ниже представлена таблица для наглядного сравнения рассмотренных технологий.

| Тип охлаждения | Энергоэффективность (PUE) | Плотность размещения оборудования | Капитальные затраты | Операционные затраты | Сложность обслуживания |

| Воздушное | ≈ 1,5-2,0 | Низкая | Низкие | Средние | Простая |

| Жидкостное (иммерсионное) | До 1,05 | Высокая (до 150 кВт/стойку) | Высокие | Низкие | Высокая |

| Фреоновое/ Гибридное | ≈ 1,15-1,3 | Средняя | Высокие | Низкие | Средняя |

Как рассчитать мощность системы охлаждения ЦОД

Расчет мощности системы охлаждения — это сложный инженерный процесс, который должен выполнять только квалифицированный специалист. От его точности зависит не только эффективность, но и стабильность работы всего дата-центра. Расчет учитывает не только текущее тепловыделение, но и потенциальные нагрузки, а также факторы, связанные с развитием IT-инфраструктуры.

Ключевые параметры для точного расчета

Расчет основывается на нескольких ключевых параметрах, включая:

- Теплопотери помещения (M1) — тепло, поступающее через ограждающие конструкции (стены, окна, потолок).

- Тепловыделение от серверного оборудования (M2).

- Тепловыделение от другого вспомогательного оборудования, например, от источников бесперебойного питания (M3).

- Коэффициент запаса мощности на нештатные ситуации (Kal), который обычно составляет около 20% от расчетной нагрузки.

- Коэффициент запаса на будущее развитие ЦОД (Kup), который может достигать 30%.

Пример расчета: пошаговая инструкция

Для наглядности рассмотрим гипотетический пример.

Допустим, объем помещения составляет V=20 м3, а тепловые потери помещения (T) равны 0,03 кВт/м3. ИТ-оборудование имеет потребляемую мощность (P) 10 кВт, а коэффициент тепловыделения серверов (Kserv) составляет 80%. Тепловыделение ИБП (Pups) примем равным 30%. Коэффициент запаса на нештатные ситуации (Kal) = 20%, а коэффициент запаса на развитие ЦОД (Kup) = 30%.

- Расчет мощности на покрытие тепловых потерь помещения:

M1 = V⋅T = 20 м3⋅0,03 кВт/м3 = 0,6 кВт

- Расчет мощности на тепловыделение от серверов:

M2 = P⋅Kserv = 10 кВт⋅80% = 8 кВт

- Расчет мощности на тепловыделение от ИБП:

M3 = P⋅Pups = 10 кВт⋅30% = 3 кВт

- Расчет общего запаса мощности на нештатные ситуации:

M4 = (M1+M2+M3)⋅Kal = (0,6+8+3) кВт⋅20% = 2,32 кВт

- Расчет запаса на развитие ЦОД:

M5 = (M1+M2+M3)⋅Kup = (0,6+8+3) кВт⋅30% = 3,48 кВт

- Расчет общей мощности системы кондиционирования:

M = M1+M2+M3+M4+M5 = 0,6+8+3+2,32+3,48 = 17,4 кВт

В данном случае общая мощность системы охлаждения должна составлять 17,4 кВт. Этот пример демонстрирует, что расчет мощности охлаждения является многофакторной задачей, которая требует учета всех источников тепла и коэффициентов запаса для обеспечения надежной работы и масштабируемости инфраструктуры.

Заключение

Охлаждение в дата-центре — это не просто вспомогательная система, а стратегически важный элемент, который напрямую влияет на надежность, экономическую эффективность и конкурентоспособность бизнеса. Недооценка проблемы перегрева может привести к непредсказуемым сбоям, потере данных и значительным финансовым потерям. В то же время, грамотно спроектированная и современная система охлаждения позволяет не только обеспечить стабильную работу оборудования, но и оптимизировать затраты на электроэнергию, что отражается в низком коэффициенте PUE.

Правильный выбор технологии охлаждения — будь то традиционное воздушное, высокоэффективное жидкостное, инновационное фреоновое или гибкое гибридное решение — должен основываться на тщательном анализе потребностей бизнеса, текущей и будущей плотности размещения оборудования, а также климатических особенностях региона. В конечном счете, инвестиции в надежные технологии охлаждения — это инвестиции в стабильное и успешное будущее вашей IT-инфраструктуры.

Ответы на частые вопросы

Как рассчитать количество кондиционеров для серверной?

Точный расчет количества кондиционеров должен выполнять инженер-проектировщик, поскольку он зависит от многих факторов: объема помещения, количества и типа установленного оборудования, а также суммарного тепловыделения. Однако существуют общие правила. Самое важное — обеспечить резервирование мощности. В одной серверной должно быть не менее двух кондиционеров, работающих по схеме N+1 (где N — количество блоков, необходимых для работы), чтобы в случае отказа одного из них, другой мог взять на себя нагрузку.

Какие проблемы чаще всего возникают с системами охлаждения?

К наиболее распространенным проблемам относятся недостаточная производительность системы, неправильная настройка оборудования, проблемы с трубопроводами и нестабильное электропитание. Недостаточная производительность может быть вызвана неверными расчетами или неправильным размещением оборудования. Ошибки в настройках (например, слишком низкая или высокая температура) могут привести к перегреву. Регулярные проверки и своевременное техническое обслуживание помогают предотвратить эти проблемы, обеспечивая стабильную и эффективную работу.

Какая температура считается оптимальной для работы серверов?

Согласно рекомендациям, оптимальная температура в машинном зале должна находиться в диапазоне от +18°С до +24°С, но не более +25°С. При этом стандарты ASHRAE допускают диапазон от 18°С до 27°С. Гораздо важнее не столько абсолютное значение температуры, сколько ее стабильность. Резкие перепады могут негативно сказаться на работе оборудования. Постоянный мониторинг температуры с помощью цифровых датчиков является критически важным для поддержания оптимального микроклимата.